【CNMO科技消息】几个月来,关于苹果计划推出AI智能穿戴设备的传闻和报道层出不穷。目前看来,苹果的智能眼镜有望在2027年左右发布,这将是Meta Ray-Bans的直接竞争对手,同时还将推出带有摄像头的AirPods,这些设备都将具备一系列AI功能。尽管目前尚不清楚这些设备的具体外观,但苹果已经向我们展示了其AI模型可能的工作方式。

2023年,苹果机器学习研究团队发布了MLX,这是苹果专为其芯片设计的开源机器学习框架。简而言之,MLX为开发者提供了一种轻量级的方式,可以在苹果设备上本地训练和运行模型,同时保持与传统AI开发框架和语言的一致性。

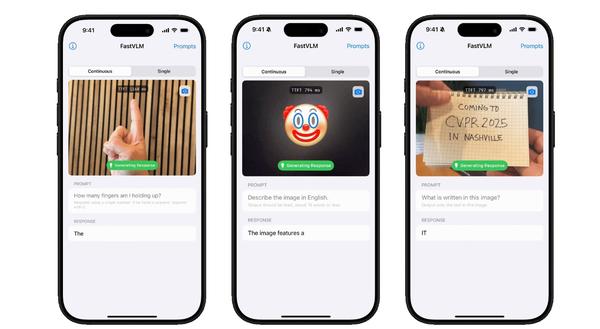

苹果的新型视觉模型FastVLM,能够快速准确地识别用户举起的手指数量、屏幕上显示的表情符号以及手写文字。

如今,苹果推出了FastVLM,这是一种视觉语言模型(VLM),它利用MLX实现近乎即时的高分辨率图像处理,同时对计算资源的需求远低于同类模型。正如苹果所说:“基于对图像分辨率、视觉延迟、标记数量和LLM大小之间相互作用的全面效率分析,我们推出了FastVLM——这是一个在延迟、模型大小和准确性之间实现优化权衡的模型。”

FastVLM的核心是一个名为FastViTHD的编码器,该编码器“专为高分辨率图像的高效VLM性能而设计”。与类似模型相比,它速度高达3.2倍,体积小3.6倍。如果设备需要在本地处理信息,而不是依赖云端来生成用户刚刚询问(或正在查看)的内容的响应,这一点至关重要。

此外,FastVLM在设计时还考虑了减少输出标记数量,这在模型解释数据并生成响应的推理阶段也至关重要。据苹果称,其模型的首次标记响应时间比类似模型快85倍,即用户发送第一个提示并收到第一个标记答案所需的时间。更少的标记、更快且更轻量的模型意味着更快的处理速度。

FastVLM的代码已在GitHub上发布,相关报告可在arXiv上找到。虽然阅读起来有一定难度,但对于对苹果AI项目技术细节感兴趣的人来说,绝对值得一读。

还没有评论,来说两句吧...